新書推薦: 《

跨界:蒂利希思想研究

》 售價:HK$

109.8

《

千万别喝南瓜汤(遵守规则绘本)

》 售價:HK$

44.7

《

大模型启示录

》 售價:HK$

112.0

《

东法西渐:19世纪前西方对中国法的记述与评价

》 售價:HK$

201.6

《

养育男孩:官方升级版

》 售價:HK$

50.4

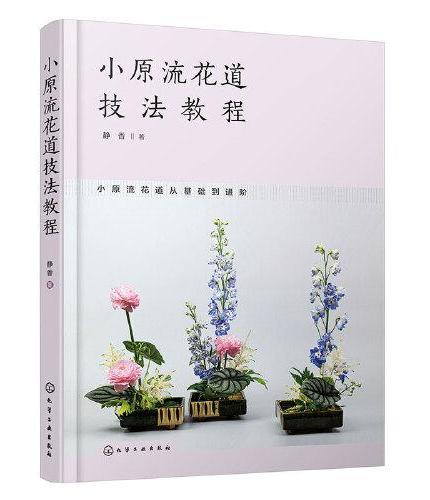

《

小原流花道技法教程

》 售價:HK$

109.8

《

少女映像室 唯美人像摄影从入门到实战

》 售價:HK$

110.9

《

詹姆斯·伍德系列:不负责任的自我:论笑与小说(“美国图书评论奖”入围作品 当代重要文学批评家詹姆斯·伍德对“文学中的笑与喜剧”的精湛研究)

》 售價:HK$

87.4

編輯推薦:

不可不读的文本学习经典著作!清华大学计算机系副主任、长聘教授唐杰,百度研究院副院长、美国罗格斯-新泽西州立大学教授熊辉,微众银行首席人工智能官、香港科技大学讲席教授杨强,美国伊利诺伊大学芝加哥分校杰出教授、Wexler信息技术主席俞士纶,联袂推荐!

內容簡介:

《文本机器学习》系统性地介绍了多个经典的和前沿的机器学习技术及其在文本域中的应用。首先,详细介绍了面向文本数据的预处理技术和经典的机器学习技术(如矩阵分解与主题建模、聚类与分类回归等),并深入探讨了模型的原理和内在联系以及相应的性能评估;其次,详细介绍了结合异构数据的文本学习技术(如知识共享与迁移学习等),以及面向信息检索与排序的索引和评分等技术;末尾,详细介绍了一些文本应用相关的重要技术,包括序列建模与深度学习、文本摘要与信息提取、意见挖掘与情感分析、文本分割与事件检测等。本书从技术原理到实际应用,综合梳理了文本机器学习的多个技术,深入分析了模型的优缺点和内在联系,并在每章结束时提供了详细的参考资料、软件资源和习题。

關於作者:

Charu C. Aggarwal是一名供职于纽约约克镇高地的IBM T. J. Watson研究中心的杰出研究员,他于1993年在坎普尔的印度理工学院获得计算机科学学士学位,并于1996年获得麻省理工学院的博士学位。他在国际会议和期刊上发表了350多篇论文,并获得了80多项专利。同时,他还以作者或参编者的身份出版了17本著作,包括数据挖掘、推荐系统和异常值分析方面的教材。他曾三次因专利的商业价值被IBM授予发明大师的荣誉。他曾获得多项内部和外部奖项,包括EDBT的时间考验奖(2014年)和IEEE ICDM研究贡献奖(2015年)。他还担任数据挖掘领域许多主要会议的程序主席或总主席,同时他还是ACM Transactions on Knowledge Discovery from Data的主编。由于在知识发现和数据挖掘算法方面的贡献,他被授予SIAM、ACM和IEEE的会士(Fellow)荣誉。

目錄

译者序

內容試閱

如果真的有不止一种理解文本的方式,那么所有解释就不可能是相同的。