新書推薦:

《

中国常见植物野外识别手册:青海册

》

售價:HK$

76.2

《

三星堆对话古遗址(从三星堆出发,横跨黄河流域,长江流域,对话11处古遗址,探源多元一体的中华文明)

》

售價:HK$

87.4

《

迷人的化学(迷人的科学丛书)

》

售價:HK$

143.4

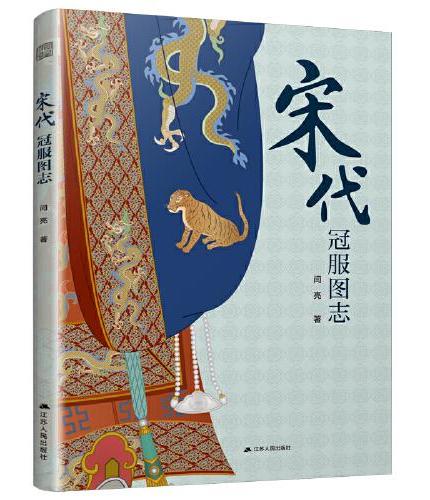

《

宋代冠服图志(详尽展示宋代各类冠服 精美插图 考据严谨 细节丰富)

》

售價:HK$

87.4

《

形似神异:什么是中日传统政治文化的结构性差异

》

售價:HK$

55.8

《

养育不好惹的小孩

》

售價:HK$

77.3

《

加加美高浩的手部绘画技法 II

》

售價:HK$

89.4

《

卡特里娜(“同一颗星球”丛书)

》

售價:HK$

87.4

|

| 編輯推薦: |

1.本卷研究了当前的神经网络技术,包括ReLU 激活、随机梯度下降、交叉熵、正则化、Dropout 和可视化; 2.丰富的示例代码和在线资源,方便动手实践与拓展学习; 3.提供在线实验环境; 4.全彩印刷; 5.《人工智能算法 卷3 深度学习和神经网络》是系列图书第3本,卷1《人工智能算法 卷1 基础算法》、卷2《人工智能算法 卷2 受大自然启发的算法》已在人民邮电出版社出版;。

自人工智能的早期阶段以来,神经网络就扮演着至关重要的角色。现在,令人兴奋的新技术,例如深度学习和卷积,正在将神经网络带向一个全新的方向。本书结合各种现实世界任务中的神经网络应用,例如图像识别和数据科学,介绍了当前的神经网络技术,包括ReLU激活、随机梯度下降、交叉熵、正则化、Dropout和可视化。

本书的目标读者是那些对人工智能感兴趣,但苦于没有良好的数学基础的人。读者只需要对大学代数课程有基本了解即可。本书为读者提供配套的示例程序代码,目前已有Java、C#和Python版本。

推荐阅读:

《人工智能算法(卷1):基础算法》ISBN:9787115523402

《人工智能算法(卷2):受大自然启

|

| 內容簡介: |

|

自早期以来,神经网络就一直是人工智能的支柱。现在,令人兴奋的新技术(例如深度学习和卷积)正在将神经网络带入一个全新的方向。在本书中,我们将演示各种现实世界任务中的神经网络,例如图像识别和数据科学。我们研究了当前的神经网络技术,包括ReLU 激活、随机梯度下降、交叉熵、正则化、Dropout 及可视化等。

|

| 關於作者: |

|

[美] 杰弗瑞希顿(Jeffery Heaton)他既是一位活跃的技术博主、开源贡献者,也是十多本图书的作者。他的专业领域包括数据科学、预测建模、数据挖掘、大数据、商务智能和人工智能等。他拥有华盛顿大学信息管理学硕士学位,是IEEE的高级会员、Sun认证Java程序员、开源机器学习框架Encog的首席开发人员。

|

| 目錄:

|

第 1 章 神经网络基础 1

1.1 神经元和层 2

1.2 神经元的类型 5

1.2.1 输入和输出神经元 6

1.2.2 隐藏神经元 7

1.2.3 偏置神经元 7

1.2.4 上下文神经元 8

1.2.5 其他神经元类型 10

1.3 激活函数 10

1.3.1 线性激活函数 10

1.3.2 阶跃激活函数 11

1.3.3 S 型激活函数12

1.3.4 双曲正切激活函数 13

1.4 修正线性单元(ReLU)13

1.4.1 Softmax 激活函数 14

1.4.2 偏置扮演什么角色? 17

1.5 神经网络逻辑 19

1.6 本章小结 22

第 2 章 自组织映射 23

2.1 自组织映射 24

2.1.1 理解邻域函数 27

2.1.2 墨西哥帽邻域函数 30

2.1.3 计算 SOM 误差 32

2.2 本章小结 33

第 3 章 Hopfield 网络和玻尔兹曼机34

3.1 Hopfield 神经网络 34

3.1.1 训练 Hopfield 网络 37

3.2 Hopfield-Tank 网络 41

3.3 玻尔兹曼机 42

3.3.1 玻尔兹曼机概率 44

3.4 应用玻尔兹曼机 45

3.4.1 旅行商问题 45

3.4.2 优化问题 48

3.4.3 玻尔兹曼机训练 51

3.5 本章小结 51

第 4 章 前馈神经网络 53

4.1 前馈神经网络结构 54

4.1.1 用于回归的单输出神经网络 54

4.2 计算输出 56

4.3 初始化权重 60

4.4 径向基函数网络 63

4.4.1 径向基函数 64

4.4.2 径向基函数网络 65

4.5 规范化数据 67

4.5.1 1-of-N 编码 68

4.5.2 范围规范化 69

4.5.3 Z 分数规范化70

4.5.4 复杂规范化 73

4.6 本章小结 75

第 5 章 训练与评估 77

5.1 评估分类 78

5.1.1 二值分类 79

5.1.2 多类分类 84

5.1.3 对数损失 86

5.1.4 多类对数损失 88

5.2 评估回归 88

5.3 模拟退火训练 89

5.4 本章小结 92

第 6 章 反向传播训练 93

6.1 理解梯度 93

6.1.1 什么是梯度 94

6.1.2 计算梯度 96

6.2 计算输出节点增量 98

6.2.1 二次误差函数 98

6.2.2 交叉熵误差函数 99

6.3 计算剩余节点增量 99

6.4 激活函数的导数 100

6.4.1 线性激活函数的导数 100

6.4.2 Softmax 激活函数的导数 100

6.4.3 S 型激活函数的导数 101

6.4.4 双曲正切激活函数的导数 102

6.4.5 ReLU 激活函数的导数 102

6.5 应用反向传播 103

6.5.1 批量训练和在线训练 104

6.5.2 随机梯度下降 105

6.5.3 反向传播权重更新 105

6.5.4 选择学习率和动量 106

6.5.5 Nesterov 动量 107

6.6 本章小结 108

第 7 章 其他传播训练 110

7.1 弹性传播 110

7.2 RPROP 参数 111

7.3 数据结构 113

7.4 理解 RPROP 114

7.4.1 确定梯度的符号变化 114

7.4.2 计算权重变化 115

7.4.3 修改更新值 115

7.5 Levenberg-Marquardt 算法 116

7.6 Hessian 矩阵的计算 119

7.7 具有多个输出的 LMA 120

7.8 LMA 过程概述 122

7.9 本章小结 122

第 8 章 NEAT,CPPN 和 HyperNEAT 124

8.1 NEAT 网络 125

8.1.1 NEAT 突变 128

8.1.2 NEAT 交叉 129

8.1.3 NEAT 物种形成 133

8.2 CPPN 网络 134

8.2.1 CPPN 表型 135

8.3 HyperNEAT 网络 138

8.3.1 HyperNEAT 基板 139

8.3.2 HyperNEAT 计算机视觉 140

8.4 本章小结 142

第 9 章 深度学习 143

9.1 深度学习组件 143

9.2 部分标记的数据 144

9.3 修正线性单元 145

9.4 卷积神经网络 145

9.5 神经元 Dropout 146

9.6 GPU 训练 147

9.7 深度学习工具 149

9.7.1 H2O 149

9.7.2 Theano 150

9.7.3 Lasagne 和 NoLearn 150

9.7.4 ConvNetJS 152

9.8 深度信念神经网络 152

9.8.1 受限玻尔兹曼机 154

9.8.2 训练 DBNN 155

9.8.3 逐层采样 157

9.8.4 计算正梯度 157

9.8.5 吉布斯采样 159

9.8.6 更新权重和偏置 160

9.8.7 DBNN 反向传播 161

9.8.8 深度信念应用 162

9.9 本章小结 164

第 10 章 卷积神经网络 165

10.1 LeNET-5 166

10.2 卷积层 168

10.3 最大池层 170

10.4 稠密层 172

10.5 针对 MNIST 数据集的 ConvNets 172

10.6 本章小结 174

第 11 章 剪枝和模型选择 175

11.1 理解剪枝 176

11.1.1 剪枝连接 176

11.1.2 剪枝神经元 176

11.1.3 改善或降低表现 177

11.2 剪枝算法 177

11.3 模型选择 179

11.3.1 网格搜索模型选择 180

11.3.2 随机搜索模型选择 183

11.3.3 其他模型选择技术 184

11.4 本章小结 185

第 12 章 Dropout 和正则化 186

12.1 L1 和 L2 正则化 187

12.1.1 理解 L1 正则化 188

12.1.2 理解 L2 正则化 189

12.2 Dropout 层 190

12.2.1 Dropout 层 191

12.2.2 实现 Dropout 层 191

12.3 使用 Dropout 194

12.4 本章小结 195

第 13 章 时间序列和循环网络 197

13.1 时间序列编码 198

13.1.1 为输入和输出神经元编码数据 199

13.1.2 预测正弦波 200

13.2 简单循环神经网络 204

13.2.1 Elman 神经网络 206

13.2.2 Jordan 神经网络 207

13.2.3 通过时间的反向传播 208

13.2.4 门控循环单元 211

13.3 本章小结 213

第 14 章 架构神经网络 214

14.1 评估神经网络 215

14.2 训练参数 215

14.2.1 学习率 216

14.2.2 动量 218

14.2.3 批次大小 219

14.3 常规超参数 220

14.3.1 激活函数 220

14.3.2 隐藏神经元的配置 222

14.4 LeNet-5 超参数 223

14.5 本章小结 224

第 15 章 可视化 226

15.1 混淆矩阵 227

15.1.1 读取混淆矩阵 227

15.1.2 生成混淆矩阵 228

15.2 t-SNE 降维 229

15.2.1 t-SNE 可视化 231

15.2.2 超越可视化的 t-SNE 235

15.3 本章小结 236

第 16 章 用神经网络建模 237

16.0.1 挑战赛的经验 241

16.0.2 挑战赛取胜的方法 242

16.0.3 我们在挑战赛中的方法 244

16.1 用深度学习建模 245

16.1.1 神经网络结构 245

16.1.2 装袋多个神经网络 249

16.2 本章小结 250

附录 A 示例代码使用说明 252

A.1 系列图书简介 252

A.2 保持更新 252

A.3 获取示例代码 253

A.3.1 下载压缩文件 253

A.3.2 克隆 Git 仓库 254

A.4 示例代码的内容 255

A.5 如何为项目做贡献 257

参考资料 259

|

|